สัมภาษณ์ผู้บริหาร Apple: เจาะลึกชิพ A11 Bionic ขุมพลัง iPhone รุ่นใหม่ การพัฒนา และส่วนสำคัญ

Apple นั้นเป็นบริษัทที่ออกแบบและพัฒนาชิพบนมือถือด้วยตัวเองมาตลอด และในชิพแต่ละอย่างก็จะมีส่วนที่เจ๋ง ๆ แตกต่างกันไปเพื่อตอสบสนองความต้องการตามฟีเจอร์ในยุคนั้น ๆ และล่าสุดคือชิพ A11 Bionic

ในรอบนี้ Mashable ได้นั่งคุยกับ Johny Srouji รองประธานอาวุโสฝ่ายเทคโนโลยีฮาร์ดแวร์ และ Phil Schiller รองประธานฝ่ายการตลาดโลกของ Apple หลังจากการเปิดตัว iPhone รุ่นล่าสุด โดยเน้นไปที่รายละเอียดเกี่ยวกับตัวชิพ A11 Bionic ซึ่งเน้นในด้านส่วนประกอบและการพัฒนาชิพเป็นหลัก

ในด้านการพัฒนาชิพนั้น Srouji กล่าวว่า Apple พัฒนาชิพก่อนหน้าที่จะออก 3 ปี ซึ่งก็หมายความว่า A11 Bionic นั้นเริ่มพัฒนามาตั้งแต่ iPhone 6 แล้ว แม้ว่าในช่วงนั้น เทรนด์ด้าน machine learning จะยังไม่ได้บูมมากถึงขนาดนี้ ซึ่งก็หมายความว่า Neural Engine ที่อยู่ในตัว A11 Bionic นั้นถูกพัฒนามาแล้ว 3 ปี (หรือมองอีกด้านคือ Apple มองถึงอนาคตอีก 3 ปีข้างหน้านั่นเอง)

การสื่อสารกันภายในของ Apple ก็เป็นส่วนสำคัญของการพัฒนาเช่นกัน อย่างเช่นทีมวิศวกรของ Srouji ก็ทำงานร่วมกับทีมการตลาดของ Schiller เพื่อมาคุยไอเดียว่า “อะไรควรจะเป็นสิ่งที่ต้องการในอีก 3 ปีข้างหน้า” ดังนั้นโร้ดแมป 3 ปีก็สามารถเปลี่ยนแปลงได้เรื่อย ๆ ถ้าทีมการตลาดขอมาแต่ไม่ได้อยู่ในแผน “ทีมวิศวกรก็ต้องทำให้ได้ เราจะไม่บอกว่า ‘ไม่ ขอกลับไปใช้โร้ดแมปเหมือนเดิม และ 5 ปีหน้าผมจะทำให้’ ”

แม้ Apple จะเป็นผู้พัฒนาชิพสำหรับ iPhone เองก็จริง แต่ Apple ไม่ได้ผลิตชิพเอง ใช้วิธีจ้างผลิต ซึ่งในการผลิตชิพนั้น Apple ก็มีทีมเทคโนโลยีขนาดเล็กที่คอยทำงานร่วมกับโรงงาน เพื่อคุยงานอย่างเช่นกำหนดการหรือการเลือกทรานซิสเตอร์อย่างใกล้ชิดกับผู้ผลิตชิพ

ทุกครั้งของการพัฒนาชิพของ Apple นั้นจะไม่ใช่การพัฒนาใหม่ทั้งหมด Srouji กล่าวว่าในทุกรุ่น เราจะนำสถาปัตยกรรมแบบเก่ามา และตัดสินใจว่าจะพัฒนาต่อหรือทำใหม่ตั้งแต่ต้น ซึ่ง A11 Bionic นำเทคโนโลยีจาก A10 Fusion บางอย่างมาพัฒนาต่อ อย่างเช่น คอร์สมรรถนะสูงและคอร์ประสิทธิภาพสูงใน A10 Fusion ก็มีการพัฒนาเพิ่มเติม โดยเพิ่ม 2 คอร์เข้าไป และสามารถจัดการ asymmetric multi-processing ได้ ซึ่งหมายความว่าชิพสามารถรัน 1, 2, 3, 4, 5 หรือ 6 คอร์ต่อครั้งก็ได้ และการจัดการคอร์บนซีพียูสถาปัตยกรรม 10nm บน A11 Bionic จึงทำให้ได้ประสิทธิภาพที่สูงกว่า A10 Fusion ถึง 70% ให้ระบบตัดสินใจว่า จะใช้คอร์ไหน (คอร์สมรรถนะสูง หรือคอร์ประสิทธิภาพสูง) เช่นถ้าเป็นเกมก็จะใช้คอร์จำนวนมากหน่อย แต่งานบางงานอาจจะดูธรรมดาอย่างเช่นการแนะนำคำถัดไป ก็อาจจะมีการสลับไปใช้คอร์สมรรถนะสูงบ้าง

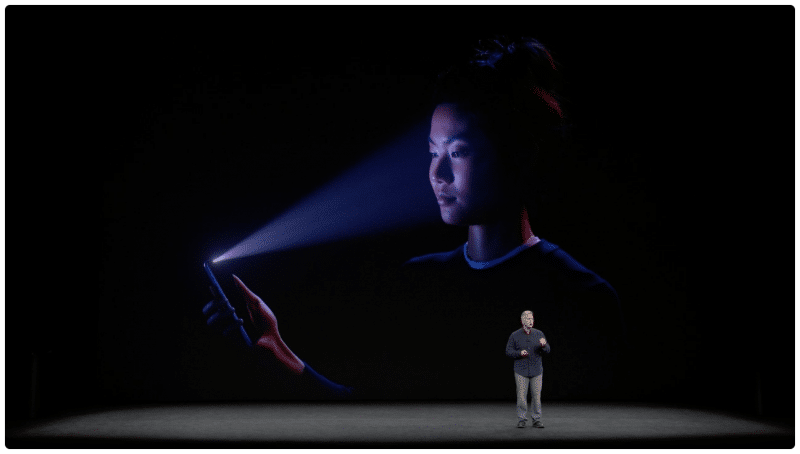

ในชิพ A11 Bionic นั้นยังมีส่วนที่ใช้ประมวลผลเฉพาะทางอีกจำนวนมาก เช่น Image Signal Processor (ISP) ที่พัฒนาเพื่อให้ประมวลผลสีและในสภาพแสงน้อย ทำให้ภาพถ่ายดูดีขึ้น รวมถึง Portrait Lighting ที่ใช้กล้องสองตัวทำการแมปปิ้งใบหน้าแบบสามมิติเพื่อสร้างเอฟเฟคแสงสตูดิโอแบบเรียลไทม์ นอกจากนี้ยังมี video encoding ที่อัพเดตให้รองรับเฟรมเรตสูงและ Slo-Mo ที่ละเอียดขึ้น, secure element ส่วนที่เก็บข้อมูลสำคัญ (อย่างเช่นลายนิ้วมือใน Touch ID หรือใบหน้าใน Face ID) ก็ออกแบบใหม่

ส่วน Neural Engine และ Graphics Engine นั้นเป็นสิ่งที่พัฒนาขึ้นใหม่หมด โดยในอดีต Apple เลือกใช้จีพียูจาก PowerVTR มาตลอด (ซึ่ง Imagination Technologies ผู้พัฒนาชิพนี้หลังจากถูก Apple ยกเลิกใช้ชิพ หุ้นก็ตกทันที 62%) การพัฒนาจีพียูเป็นงานใหญ่ เพราะ Apple ต้องทำเองทุกอย่างตั้งแต่ฮาร์ดแวร์กราฟิก, คอมไพเลอร์, ภาษาโปรแกรมมิ่ง จนถึงระดับระบบปฏิบัติการ, เฟรมเวิร์ค และไลบรารี ซึ่ง Schiller กล่าวว่ามันไม่ได้เหมือนเลโก้ที่เอามาต่อ ๆ กัน ทีมต้องพัฒนาขึ้นมาเพื่อให้ทำงานด้วยกันได้

ด้วยการพัฒนาชิพของ Apple เอง ทำให้ iPhone มีประสิทธิภาพที่ดีขึ้น Apple มีวิธีจัดการกับซิลิคอนเมื่อมันกำลังอยู่ในโหมดหลับ เมื่ออุปกรณ์ไม่แอคทีฟ Apple ไม่ต้องการให้แบตเตอรี่หมดไปในขณะที่ผู้ใช้ไม่ได้ใช้เครื่อง ซึ่งเรียกว่า low leakage คือเมื่อผู้ใช้ไม่ใช้ ก็คือผู้ใช้ไม่ได้ใช้อยู่

ผลจากการพัฒนาสังเกตได้ว่า แม้เครื่องจะอยู่ในโหมดหลับ แต่พอหยิบเครื่องขึ้นมาก็จะเปิดจออัตโนมัติ (ฟีเจอร์ Raise to Wake)

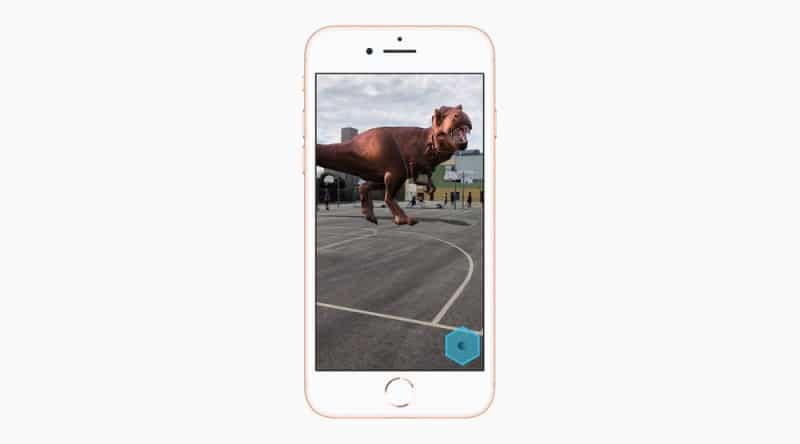

Neural Engine ก็เป็นสิ่งสำคัญมาก เพราะว่าฟีเจอร์อย่าง Face ID, ระบบตรวจจับวัตถุของ AR ทั้งหมดนี้ใช้ neural network และ machine learning ทั้งนั้น ส่วนของ Neural Engine จึงเป็นส่วนที่สำคัญและแตกต่างจากส่วนอื่นในชิพอย่างมาก Apple ต้องออกแบบ Neural Engine ให้จัดการการคูณเมทริกซ์ และการประมวลผลแบบ floating-point ซึ่งถือเป็นส่วนประมวลผลสำคัญในงานด้านนี้ให้ดี โดย Schiller กล่าวว่า Neural Engine นั้นเหมาะสำหรับงานชุดหนึ่ง ไม่ใช่ส่วนที่ใช้ทำงานทั่วไป

ในด้านนักพัฒนาแอพภายนอกก็สามารถใช้ Neural Engine ได้ผ่านเฟรมเวิร์คของ Apple อย่าง ARKit ซึ่งเป็นเครื่องมือ AR ที่ Apple เตรียมไว้ให้ใน iOS 11

ส่วนอื่นใน A11 Bionic ที่ Apple ไม่ได้อธิบายมาก อย่างเช่น storage controller ที่มาพร้อมกับอัลกอริทึม error-correcting code (ECC) ก็เป็นส่วนสำคัญในการจัดการหน่วยความจำเช่นกัน หรือ Digital Signal Processor (DSP) ซึ่งเป็นส่วนสำคัญในการให้เสียงที่มีคุณภาพ

หากใครมีความรู้ในด้านการพัฒนาชิพบ้าง อาจจะพอรู้มาบ้างว่าซิลิคอนทุกวันนี้เริ่มเข้าใกล้ถึงขีดจำกัดในการพัฒนาตามกฎของฟิสิกส์แล้ว ดังนั้นเมื่อ Mashable ถามเรื่องนี้กับ Srouji ว่า Apple ได้นึกถึงโซลูชั่นของซิลิคอนในอนาคต (หรืออาจจะเปลี่ยนเป็นวัสดุอื่น) หรือยัง? เขาก็ตอบว่า Apple ได้คิดไว้ล่วงหน้าก่อนเสมอ

ที่มา – Mashable

แปลและเรียบเรียงใหม่โดย

ทีมงาน MacThai